記事

2023年8月4日

医療AIにおける公平性を考える:国内ステークホルダーと紡いだレビューと推奨

医療現場で広がりつつあるAIの偏りや差別のリスクを整理し、患者一人ひとりに公平な恩恵をもたらすための方策をまとめた論文です。

論文

Fairness of artificial intelligence in healthcare: review and recommendations

Japanese Journal of Radiology

https://doi.org/10.1007/s11604-023-01474-3

著者談

本論文は、日本全国の医療AIに関わるステークホルダーの方々に加え、セカンドオーサーとしてAI分野で著名な弁護士の柿沼太一先生に参加していただき、総力を結集して完成させました。実際にAIが医療の現場で利用されるようになった今こそ、その公平性やバイアスを正面から議論する必要があると感じ、私たちは執筆の早い段階からステークホルダーと意見交換を重ねてきました。さらに、大規模言語モデル(LLM)を用いつつ何度も推敲を繰り返したことで、より多角的で客観的な視点を盛り込むことができたと思います。この成果が多くの注目を集めたのか、発表後は引用数が急増し、2024年の一年間だけでも150回以上引用されました(Google Scholar調べ)。それだけ多くの方々の関心に支えられていることに、大きな責任とやりがいを感じています。

論文概要

本稿は、日本放射線学会誌(Japanese Journal of Radiology)に掲載されたオープンアクセスの総説論文です。AI診断を含む医療行為で懸念されるバイアスや不公平な結果が、患者の健康や治療機会にどのような影響を及ぼすかを理論的・実践的視点の双方から整理しました。そして、多様性のあるデータセットを用意したり、医療従事者やAI開発者、行政・患者団体などが連携したりする重要性を強調し、適切な倫理的・法的フレームワークのもとでAIを導入するための推奨を示しています。放射線診断は特にAIの導入が進んでいる領域であるため、私たちはこれまでの国内研究成果を踏まえつつ、公平性への取り組みがどれほど急務かを改めて論じました。

論文詳細

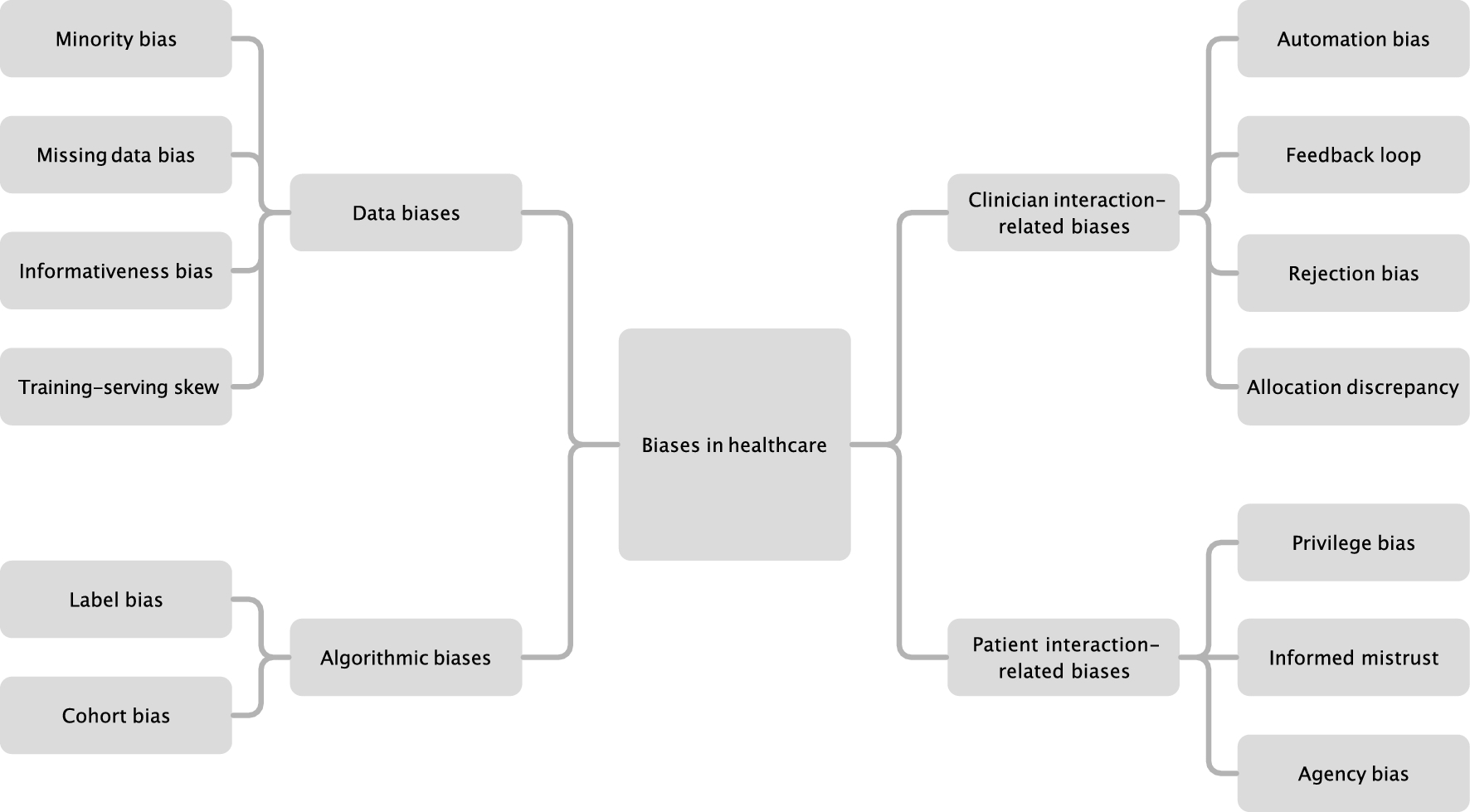

まず、公平性とは患者の人種や社会的地位、性別、年齢などにかかわらず、誰もが適切な医療を受けられる状態を指すことを定義しました。そこから、データの偏りやアルゴリズム自体の構造的問題によって引き起こされる差異が、現場で見過ごされる危険性を指摘しています。たとえば胸部X線のAI診断モデルが、ある特定の集団の症例ばかりを学習すると、他の集団で誤差が増大するリスクが生じることを複数の報告(内部評価や外部検証)から示しました。私たちはこれを防ぐために、開発段階でのデータ収集を多様化し、さらに運用開始後も独立機関によるアルゴリズム監査を定期的に行うよう提案しています。また、バイアスを正しく理解し対処するには、医療従事者だけでなく患者もAI技術に関する基礎知識を得る必要があります。そのため教育プログラムの整備も推奨し、患者側の選択を支える環境づくりを重視しました。こうした一連の取り組みを通じて、医療AIが誰にも偏りなく貢献し得る体制を築くことこそ、今まさに私たちが果たすべき責務だと考えています。