記事

2025年3月22日

生成AIと医師の診断精度を比較する大規模メタ分析

生成AIによる診断力を広く調査しまとめ、専門医には及ばずも非専門医とは同等の結果を得ました。

論文

npj Digital Medicine

https://doi.org/10.1038/s41746-025-01543-z

著者談

私たちは、最初にRadiology誌の「Diagnostic Performance of ChatGPT from Patient History and Imaging Findings on the Diagnosis Please Quizzes」において、臨床における生成AIの診断能を検証する研究を開始しました。その後、放射線科領域で7本、全医療分野で1本の原著論文を発表し、今回の研究はそれらを含めて世界中から同様の論文を収集し、解析したものです。長期的な視点で全体の研究計画をデザインし、最終的に一連の研究を完遂できたことを大変うれしく思っています。

論文概要

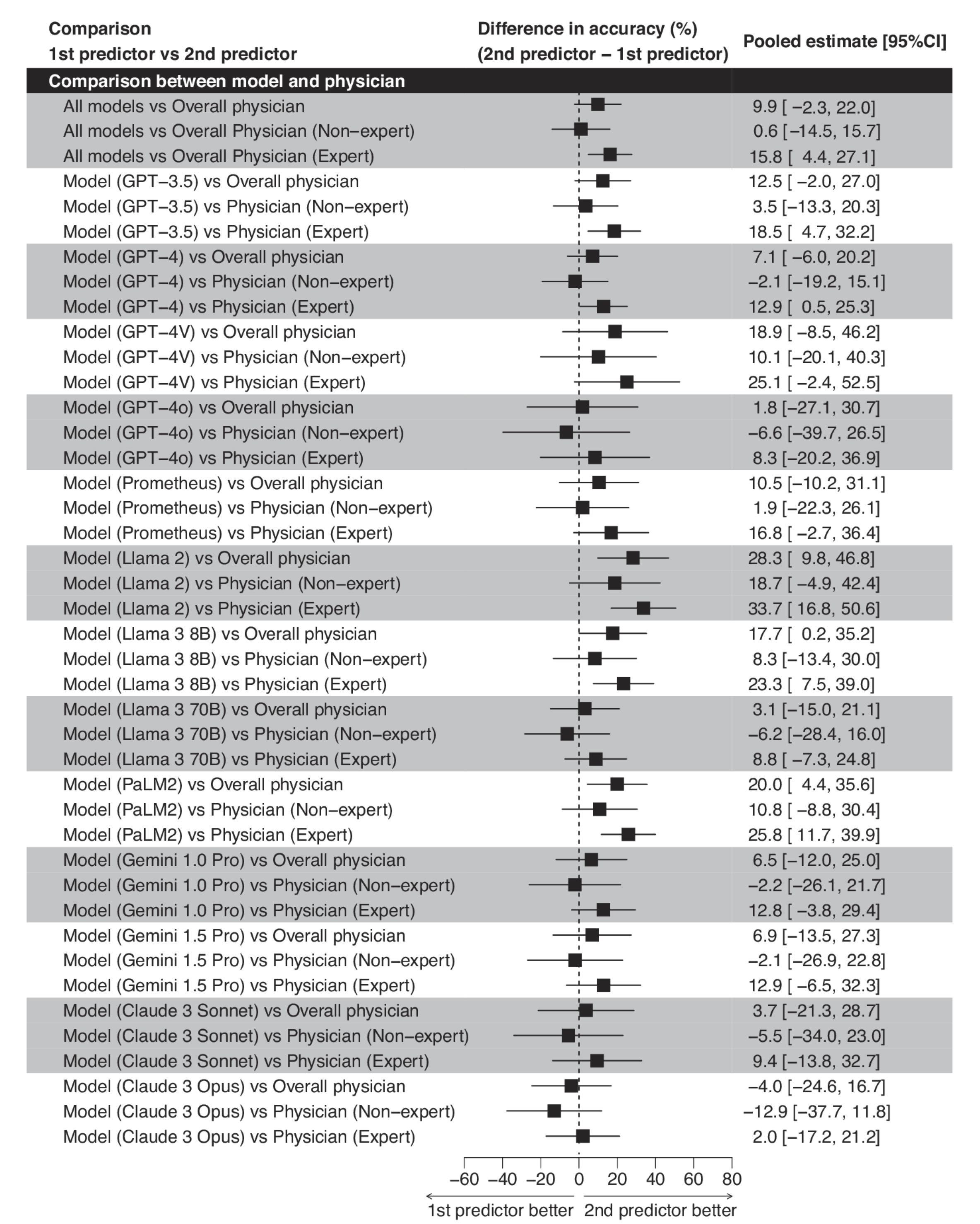

本研究は2025年3月22日にnpj Digital Medicineで公開されたオープンアクセスの論文です。2018年6月から2024年6月までに公表された83件の研究を体系的に解析し、各種生成AIモデルの診断精度を検証しました。結果として、生成AI全体の正答率は52.1%でした。一部の最新の生成AIモデルでは非専門医よりも有意差はなくとも高い性能を示したことが印象的でした。

論文詳細

私たちは複数のデータベースから合計18,371件の文献を抽出し、重複や基準を満たさないものを除外したうえで、最終的に83件の研究を対象にメタ解析を行いました。多様な生成AIモデルの診断能を比較したところ、非専門医との差はわずか0.6%程度にとどまり(p=0.93)、生成AIが一定の範囲で医療実務を補完できる可能性が示唆されました。さらには、一部の最新のモデル(GPT-4, GPT-4o, Llama3 70B, Gemini 1.0 Pro, Gemini 1.5 Pro, Claude 3 Sonnet, Claude 3 Opusなど)では、非専門医より有意差はないもののわずかに高い性能を示しました。一方で、専門医と比べると依然として差が残り、特に高度な臨床知識が求められる場面では生成AIの限界が明確になっています。さらに診療科ごとの精度差も大きくなく、特定分野で突出した成果が得られるわけではありませんでした。本研究では多くの対象論文がバイアスリスクを抱えることも指摘され、今後は学習データの透明性と外部検証の充実が課題となります。私たちは、現段階では専門医のレベルには至らないものの、生成AIが学習や診断補助の一助となる余地は十分にあると考えており、今後はより実践的な環境下での精度検証を進めていく予定です。